AlphaEvolve – samodoskonalący się system AI od Google DeepMind

AlphaEvolve to rzeczywisty, oficjalnie ogłoszony projekt sztucznej inteligencji od Google DeepMind, a nie jedynie plotka czy koncepcja. Został on publicznie zaprezentowany 14 maja 2025 r. – Google DeepMind „uchyliło rąbka tajemnicy” i przedstawiło AlphaEvolve jako agenta AI, który potrafi wymyślać zupełnie nowe algorytmy komputerowe i od razu wdrażać je wewnątrz infrastruktury firmy. Projekt opisano w białej księdze opublikowanej tego samego dnia, a informacje te zostały szeroko zrelacjonowane w branżowych mediach technologicznych (m.in. VentureBeat, Scientific American, IEEE Spectrum). Mamy więc do czynienia z potwierdzonym projektem badawczym Google, który już funkcjonuje wewnętrznie – według Google, nowe algorytmy wypracowane przez AlphaEvolve zostały wdrożone m.in. w centrach danych firmy czy przy projektowaniu układów scalonych. Nie jest to zatem czysto teoretyczna idea, lecz praktycznie testowany system.

Warto podkreślić, że AlphaEvolve znajduje się na razie na etapie zaawansowanych badań/rozwoju i nie stanowi produktu komercyjnego dostępnego publicznie. Jest to narzędzie wewnętrzne, działające w infrastrukturze Google – obecnie brak otwartej wersji do samodzielnego uruchomienia. Google zapowiedziało jednak program wczesnego dostępu (Early Access) dla wybranych naukowców akademickich oraz prace nad przyjaznym interfejsem użytkownika, aby w przyszłości udostępnić AlphaEvolve szerszemu gronu. Oznacza to, że choć technologia jest oficjalna i realna, to pozostaje proprietarna (zamknięta) i eksperymentalna.

Kod źródłowy nie został opublikowany; co więcej, duże wymagania obliczeniowe systemu uniemożliwiają swobodne udostępnienie go publicznie w obecnej formie. Niezależni badacze zapowiadają próby odtworzenia jego funkcjonalności w projektach open-source, jednak na razie bazujemy głównie na informacjach od Google. Z tego względu zewnętrzni eksperci zachowują ostrożność – dopóki AlphaEvolve nie zostanie zweryfikowany poza laboratoriami Google, należy podchodzić do jego rewelacji z rezerwą. Niemniej wszystkie dostępne dane (oficjalne blogi techniczne Google, recenzje w mediach naukowych) potwierdzają, że AlphaEvolve faktycznie istnieje i osiągnął opisane rezultaty.Architektura i sposób działania

Schemat: Diagram architektury systemu AlphaEvolve, pokazujący rolę badacza (dostarczającego szablon promptu, model LLM i kryteria oceny) oraz poszczególne komponenty agenta: moduł generujący prompt, zespół modeli LLM, pulę ewaluatorów (automatycznie testujących rozwiązania) i bazę programów (przechowującą kandydatów na algorytmy). W dolnej części widać pseudokod pętli ewolucyjnej: najpierw z bazy wybierany jest aktualny program, następnie generator promptu buduje na jego podstawie zapytanie do modelu językowego (LLM), który proponuje modyfikację kodu (diff) – tę modyfikację stosuje się do programu, a otrzymane rozwiązanie ewaluator automatycznie uruchamia i ocenia według zdefiniowanych metryk. Wyniki są zapisywane w bazie i kolejne iteracje pętli wykorzystują najlepsze dotąd rozwiązania jako punkt wyjścia. Dzięki takiej iteracyjnej procedurze AlphaEvolve stopniowo ulepsza rozwiązanie, ewoluując kod aż do uzyskania najlepszego znalezionego programu.

AlphaEvolve łączy w sobie techniki generowania kodu przez duże modele językowe z klasycznym podejściem ewolucyjnym (znanym z genetic programming). Jego działanie wymaga od użytkownika formalnego zdefiniowania zadania – musi on podać funkcję oceny (ewaluacyjną), która dla danego rozwiązania zwraca mierzalne wskaźniki jakości. Na tej podstawie system potrafi automatycznie porównywać różne wygenerowane programy i wybierać lepsze. Takie podejście zapewnia uniwersalność: AlphaEvolve można zastosować do praktycznie każdego problemu, który da się zapisać w formie programu komputerowego i którego poprawność/wydajność można automatycznie zmierzyć za pomocą kodu – od zadań matematycznych po optymalizację systemów komputerowych. W praktyce, w każdym uruchomieniu użytkownik dostarcza początkowe rozwiązanie (program startowy) oraz kryteria sukcesu, a AlphaEvolve iteracyjnie ten program ulepsza.

Aby skutecznie eksplorować przestrzeń rozwiązań, AlphaEvolve wykorzystuje kombinację modeli językowych. W szczególności używa dwóch wariantów nowego modelu LLM Google o nazwie Gemini: Gemini Flash (model zoptymalizowany pod kątem szybkości) generuje bardzo wiele różnorodnych propozycji rozwiązań, zaś Gemini Pro (najpotężniejsza wersja modelu) dostarcza bardziej dogłębne, dopracowane pomysły. W ten sposób łączy się szeroką eksplorację pomysłów z ich eksploatacją (ulepszaniem najbardziej obiecujących rozwiązań). Dzięki temu agent jest w stanie tworzyć złożone algorytmy sięgające setek linii kodu, zawierające skomplikowaną logikę – znacznie bardziej rozbudowane niż pojedyncze funkcje czy krótkie skrypty. To istotny postęp względem wcześniejszych demonstracji, gdzie modele generowały jedynie fragmenty kodu: AlphaEvolve potrafi ewoluować całe codebase (czyli większe programy) w kierunku coraz lepszych wyników.

Należy zaznaczyć, że kluczowym elementem zapewniającym skuteczność tego systemu jest automatyczna weryfikacja – AlphaEvolve samodzielnie uruchamia wygenerowany kod i mierzy jego wynik w odniesieniu do metryk podanych przez użytkownika. Rozwiązania poprawne i bardziej wydajne są zachowywane, a słabsze odrzucane. Ten automatyczny feedback loop pozwala agentowi uczyć się na własnych błędach i sukcesach, bez potrzeby ciągłej interwencji człowieka. W efekcie algorytmy “wyhodowane” przez AlphaEvolve często przewyższają te, które człowiek mógłby zaprojektować ręcznie – system eksploruje nietypowe, kreatywne modyfikacje, które następnie są rygorystycznie testowane w celu wyłonienia najlepszych kandydatów.

Zastosowania i dotychczasowe osiągnięcia

Najważniejsze odnotowane osiągnięcia i zastosowania AlphaEvolve obejmują m.in.:

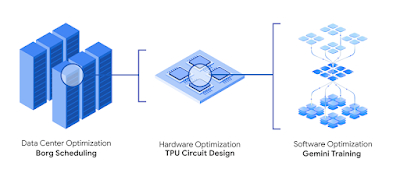

Optymalizacja centrów danych: agent odkrył nową, prostą lecz skuteczną heurystykę dla systemu orkiestracji zadań Borg, dzięki czemu odzyskano średnio 0,7% zasobów obliczeniowych we wszystkich centrach danych Google. Mówiąc inaczej, w dowolnym momencie o 0,7% więcej zadań może być wykonanych na tej samej infrastrukturze – to trwały wzrost efektywności wykorzystania serwerów.

Wspomaganie projektowania sprzętu: AlphaEvolve zaproponował modyfikację kodu Verilog kluczowego obwodu arytmetycznego (odpowiedzialnego za mnożenie macierzy) w projektowanym akceleratorze TPU. Usunięto zbędne bity/operacje, zachowując pełną poprawność funkcjonalną układu, co zostanie zaimplementowane w kolejnej generacji chipu TPU. Innymi słowy, AI znalazła usprawnienie mikroarchitektury, które inżynierowie sprzętu włączą do nowego procesora – pokazuje to, że system może współpracować z ludźmi, wskazując im nietypowe ulepszenia designu hardware.

Przyspieszenie treningu modeli AI: AlphaEvolve odnalazł sprytniejszy sposób wykonywania dużych mnożeń macierzowych (poprzez rozbijanie ich na mniejsze podzadania) w algorytmicznej “kuźni” modelu Gemini. Pozwoliło to przyspieszyć kluczowe jądro obliczeń o 23%, co z kolei skróciło całkowity czas trenowania modelu językowego o ~1%. Dodatkowo agent zautomatyzował optymalizację pewnych niskopoziomowych instrukcji GPU – np. usprawnił implementację algorytmu FlashAttention (używanego w modelach Transformer) o aż 32,5%, mimo że dotychczas uważano go za maksymalnie zoptymalizowany przez kompilatory. Takie ulepszenia nie tylko przyspieszają działanie systemów AI, ale też oszczędzają tygodnie pracy ekspertów, którzy normalnie ręcznie dostrajali by kod dla uzyskania podobnych przyspieszeń.

Nowe algorytmy matematyczne: w dziedzinie czystej informatyki AlphaEvolve odkrył m.in. szybszy algorytm mnożenia macierzy 4×4 (dla liczb zespolonych), wymagający wykonania jedynie 48 mnożeń skalarów. Tym samym pobił on rekord ustanowiony przez niemiecki matematyczny Volkmara Strassena w 1969 roku (jego klasyczny algorytm mnożył macierze 4×4 wolniej). Co ważne, nawet wcześniejszy wyspecjalizowany system DeepMind o nazwie AlphaTensor (który w 2022 r. zajmował się wyłącznie mnożeniem macierzy) nie znalazł tak dobrego rozwiązania dla 4×4 w dziedzinie liczb zespolonych – AlphaEvolve okazał się więc skuteczniejszy od poprzednika mimo dużo szerszego zakresu działania.

Rozwiązywanie problemów otwartych: AlphaEvolve z powodzeniem zaatakował szereg trudnych problemów matematycznych, nad którymi od lat głowili się ludzie. Google przetestowało go na ponad 50 różnych otwartych problemach z analizą matematyczną, geometrią, kombinatoryką i teorią liczb – w około 75% przypadków AI odnalazła znane już najlepsze rozwiązania (co stanowi walidację podejścia), a w **20% przypadków zaproponowała nowe, lepsze od dotychczasowych rezultaty. Każdy taki przypadek to nowe odkrycie naukowe dokonane przez AI. Na przykład w słynnym problemie “kissingu” (zagadnieniu o maksymalnej liczbie sfer stykających się z daną sferą w N wymiarach) AlphaEvolve poprawił najlepszy znany wynik w 11 wymiarach – zwiększył dolną granicę liczby stycznych kul z 592 do 593. Choć to zaledwie jedna dodatkowa kula, jest to nowy rezultat matematyczny uzyskany autonomicznie przez AI, przekraczający to, co osiągnęli ludzie w ciągu 50 lat badań nad tym problemem. To dowód, że duży model językowy potrafi generować oryginalne wkłady naukowe w matematyce.

Warto zauważyć, że powyższe sukcesy dotyczą zadań, które mają jasno zdefiniowane kryteria jakości (np. zminimalizowanie użycia zasobów, poprawność algorytmu, liczba operacji itp.). W takich warunkach AlphaEvolve błyszczy – jest w stanie nie tylko dorównać ekspertom, ale nieraz ich prześcignąć, proponując nieszablonowe rozwiązania. Przykładem jest ulepszenie heurystyki planowania zadań: agent odkrył prostą regułę, która odzyskała ułamek mocy obliczeniowej, co jednak w skali Google dało oszczędności rzędu wielu milionów dolarów rocznie. Znaczenie praktyczne jest więc ogromne – nawet ułamkowe usprawnienia mogą przekładać się na realne zyski i postęp.

Powiązania z innymi inicjatywami AI Google

Projekt AlphaEvolve należy umiejscowić w kontekście szerszych działań Google w dziedzinie AI. Po pierwsze, jest to dzieło zespołu Google DeepMind, czyli połączonych sił dawnego DeepMind i Google Brain – stanowi więc efekt połączenia zaawansowanych algorytmów uczenia (reinforcement learning, ewolucja) typowych dla DeepMind z potężnymi modelami językowymi rozwijanymi przez Google. Nazwa wpisuje się w tradycję przełomowych projektów DeepMind oznaczanych przedrostkiem Alpha- (jak AlphaGo, AlphaZero, AlphaFold, AlphaTensor itp.). Jednak w przeciwieństwie do nich – które były wyspecjalizowane w jednej dziedzinie (gry planszowe, białka, mnożenie tensorów) – AlphaEvolve jest pomyślany jako system bardziej ogólnego przeznaczenia. Wykorzystuje on uniwersalne zdolności dużego modelu językowego do pisania kodu, by rozwiązywać dowolny problem algorytmiczny, podczas gdy wcześniejsze “Alphy” bazowały na konkretnych, ręcznie zaprojektowanych rozwiązaniach dla swoich domen. Zdaniem komentatorów, jest to pierwsza tak udana demonstracja, że ogólny model LLM potrafi generować nowe odkrycia naukowe, a nie jedynie odtwarzać istniejącą wiedzę.

Sercem AlphaEvolve jest model z rodziny Gemini, czyli najnowsza generacja dużych modeli językowych Google. Gemini to następca rodziny modeli PaLM – zapowiadany jako potężny, wszechstronny model AI nowej generacji, łączący techniki multimodalne i zdolności na poziomie zbliżonym do GPT-4. W AlphaEvolve wykorzystano dwie instancje tego modelu (jak opisano wyżej: Flash i Pro), co potwierdza, że system ten jest ściśle powiązany z najnowszymi osiągnięciami Google w obszarze LLM. Innymi słowy, AlphaEvolve to w pewnym sensie “pokaz możliwości” platformy Gemini – demonstruje, jak inteligencja językowa Gemini może zostać użyta do rzeczy znacznie ambitniejszych niż chatbot czy asystent programisty, bo aż do autonomicznego projektowania algorytmów.

Z drugiej strony, AlphaEvolve rozwija idee AutoML i systemów do automatycznego ulepszania modeli/algorytmów, nad którymi Google pracuje od lat. Już w 2017 r. Google Brain tworzył narzędzia AutoML do automatycznego strojenia architektur sieci neuronowych, a w 2020 r. zaprezentowano koncepcję AutoML-Zero – algorytmu, który ewoluuje fragmenty kodu uczącego się od zera, bez ludzkiej inżynierii. AlphaEvolve można postrzegać jako kolejny krok na tej ścieżce: zamiast optymalizować wyłącznie hiperparametry czy architekturę sieci neuronowej, system ten pisze cały kod algorytmu (niekoniecznie sieci neuronowej) i optymalizuje go pod zadane kryteria. W ten sposób Google automatyzuje proces odkrywania nowych algorytmów, co dawniej było domeną ludzkich programistów i naukowców. To podejście przypomina też wcześniejsze prace DeepMind nad automatycznym odkrywaniem algorytmów – np. system AlphaDev (2023) nauczył się odkrywać efektywne algorytmy sortowania i haszowania w asemblerze, zaś AlphaTensor (2022) znajdował nowe schematy mnożenia macierzy. AlphaEvolve generalizuje te wysiłki: nie skupia się na jednym typie problemu, lecz stanowi platformę mogącą rozwiązywać wiele różnych zadań (byle dało się je ubrać w formę programów i testów). Można więc powiedzieć, że AlphaEvolve stoi na skrzyżowaniu dróg dwóch dużych trendów w AI: potężnych modeli językowych (PaLM → Gemini) oraz samooptymalizujących się systemów AutoML/AutoAI.

W kontekście innych znanych projektów Google, AlphaEvolve komplementuje i wykorzystuje ich osiągnięcia zamiast je zastępować. Na przykład, model PaLM 2 (zaprezentowany w 2023 r.) był wykorzystywany głównie do zadań językowych i jako baza dla chatbotów – AlphaEvolve natomiast pokazuje, że podobne modele mogą zostać “wykorzystane jako mózg” systemu rozwiązującego problemy inżynierskie i naukowe. Z kolei technologia Google AutoML automatyzowała projektowanie sieci neuronowych; AlphaEvolve idzie dalej, automatyzując projektowanie algorytmów ogólnego rodzaju. Wreszcie, DeepMind Gemini (wspomniany model LLM) sam w sobie jest wynikiem połączenia wiedzy zespołów Google Brain (twórców m.in. PaLM) i DeepMind – AlphaEvolve zrodził się więc naturalnie z tego połączenia, łącząc model generatywny z pętlą ewaluacyjno-optymalizacyjną typową dla projektów DeepMind. Można przypuszczać, że kolejne projekty Google (np. Gemini jako platforma, czy przyszłe modele z rodziny PaLM/GPT) będą czerpać z doświadczeń AlphaEvolve, aby uczynić AI bardziej „agentową” i samodoskonalącą się.

Ocena wiarygodności informacji i perspektywy

Informacje na temat AlphaEvolve pochodzą z wiarygodnych źródeł: przede wszystkim z oficjalnego bloga Google DeepMind (który przedstawił szczegóły techniczne i białą księgę projektu), a także z renomowanych czasopism naukowych i mediów branżowych (Scientific American, IEEE Spectrum, VentureBeat, InfoQ) komentujących to osiągnięcie. Możemy więc uznać je za dobrze potwierdzone, choć oczywiście większość danych jest dostarczona przez samych autorów systemu. W Scientific American opisano AlphaEvolve jako system łączący kreatywność modelu LLM z algorytmami oceniającymi i poprawiającymi jego propozycje. Niezależni eksperci, tacy jak dr Mario Krenn z instytutu Max Planck, ocenili tę pracę entuzjastycznie – nazywając ją „spektakularną” i pierwszą udaną demonstracją, że ogólne modele AI mogą dokonywać nowych odkryć naukowych. Takie komentarze potwierdzają, że AlphaEvolve budzi duże zainteresowanie i wiąże się z nim nadzieje na przełom w sposobie prowadzenia badań.

Z drugiej strony, w środowisku naukowym pojawiają się też głosy ostrożne i krytyczne. Zwraca się uwagę, że zakres zastosowań AlphaEvolve mimo wszystko jest ograniczony – system ten sprawdzi się tylko tam, gdzie dysponujemy formalnym opisem problemu i jednoznaczną metryką jakości rozwiązania. Simon Frieder (matematyk i badacz AI z Oxfordu) ocenia, że AlphaEvolve przyspiesza rozwiązywanie pewnych zagadnień matematycznych, ale zapewne znajdzie zastosowanie jedynie w dość „wąskim wycinku” zadań, które da się przedstawić jako problem do optymalizacji przez kod. Innymi słowy, wiele realnych wyzwań nauki (np. z dziedzin, gdzie kryteria sukcesu są subiektywne lub trudno mierzalne) może nie nadawać się do tego podejścia. Ponadto badacze tacy jak Huan Sun (Ohio State University) podkreślają, że niezależna weryfikacja jest kluczowa – dopóki społeczność spoza Google DeepMind nie przetestuje tego narzędzia, należy podchodzić do wyników z pewną rezerwą i „szczyptą soli”. Rzeczywiście, jak dotąd wszystkie rewelacje (np. nowy rekord w problemie kissingu czy ulepszenia w TPU) pochodzą z raportów samego zespołu AlphaEvolve. Choć udostępniono materiały pomocnicze – w tym białą księgę z dokładnymi wynikami oraz notatnik Colab prezentujący matematyczne odkrycia AI – to pełna ocena wiarygodności tych wyników przyjdzie z czasem, gdy inni będą mogli je zreplikować lub wykorzystać.

Na obecną chwilę można stwierdzić, że AlphaEvolve to zaawansowana, eksperymentalna technologia, potwierdzona oficjalnie przez Google, lecz wymagająca dalszych testów. Nie jest to projekt open-source ani ogólnodostępny – stanowi własność Google DeepMind i działa na ich zamkniętej infrastrukturze. Co więcej, uruchomienie AlphaEvolve wymaga ogromnej mocy obliczeniowej, porównywalnej z tą potrzebną do trenowania dużych modeli AI, więc przeciętny zespół badawczy nie mógłby go łatwo powielić. Sama firma przyznała, że system jest zbyt zasobożerny, by udostępnić go publicznie w formie np. otwartego APIm. W odpowiedzi Google zaplanowało wspomniany program Early Access – licząc, że kolektywna inteligencja naukowców pomoże wskazać kolejne obszary nauki, w których warto zastosować AlphaEvolve. Innymi słowy, Google zachęca środowisko naukowe do współpracy: do proponowania nowych problemów, które ten agent mógłby spróbować rozwiązać. To sugeruje, że projekt jest w fazie aktywnego rozwoju i rozszerzania zastosowań.

Z perspektywy technologicznej wiarygodność AlphaEvolve ocenić można umiarkowanie wysoko, z zastrzeżeniem, że obecnie jesteśmy zdani na dane od autorów. Pewnym pozytywnym sygnałem jest fakt, że Google wdrożyło już niektóre wygenerowane algorytmy do krytycznych systemów (centra danych, układy TPU) – trudno wyobrazić sobie, by firma zastosowała je produkcyjnie bez solidnej weryfikacji wewnętrznej. To zwiększa zaufanie do jakości tych rozwiązań. Z drugiej strony, badacze jak Frieder wolą poczekać, aż powstanie niezależna, otwarta implementacja (lub replikacja) AlphaEvolve, zamiast opierać się na nieprzejrzystym, zamkniętym systemie DeepMind. Można przewidywać, że w najbliższych miesiącach powstaną akademickie prace i projekty open-source inspirowane AlphaEvolve – być może potwierdzając (lub falsyfikując) jego osiągnięcia na mniejszych, dostępnych publicznie wersjach.

Perspektywy rozwoju AlphaEvolve są niezwykle interesujące. Google twierdzi, że choć dotychczas zastosowano go głównie w matematyce i informatyce, to ma on ogólny charakter, który pozwoli użyć go w dowolnej dziedzinie wymagającej algorytmicznych rozwiązań. W białej księdze zasugerowano potencjalne obszary jak materiały (np. projektowanie nowych materiałów), chemia i medycyna (np. odkrywanie leków), zrównoważony rozwój czy nawet biznes – wszędzie tam, gdzie problem da się sformalizować jako ciąg działań (algorytm) i ocenić wyniki eksperymentalnie. Jeśli AlphaEvolve spełni te nadzieje, może to oznaczać narodziny nowego paradygmatu w nauce i inżynierii: autonomicznych “badaczy AI”, którzy będą partnerami dla ludzi, przeszukując przestrzeń pomysłów z niespotykaną dotąd skalą i szybkością. Na razie jednak należy pamiętać, że to wciąż projekt badawczy. Pierwsze rezultaty – choć imponujące – muszą zostać zweryfikowane przez niezależne eksperymenty. Dopiero wtedy przekonamy się, na ile AlphaEvolve faktycznie zrewolucjonizuje tworzenie algorytmów.

Podsumowując, AlphaEvolve jest oficjalnym, pionierskim narzędziem AI od Google DeepMind, którego funkcją jest samodzielne rozwijanie i ulepszanie kodu w celu rozwiązywania złożonych problemów. Jego główne cele to automatyczne odkrywanie nowych algorytmów i optymalizacji, co potwierdzono już na przykładach z infrastruktury Google i matematyki. Technologicznie plasuje się on na przecięciu osiągnięć DeepMind (seria „Alpha”) i Google Brain (modele pokroju PaLM/Gemini), wykorzystując LLM do ewolucyjnego ulepszania programów. Informacje o AlphaEvolve pochodzą z rzetelnych źródeł (blog Google, artykuły naukowe) i wskazują na realne, choć wstępne sukcesy systemu. Należy jednak mieć na uwadze, że jest to rozwiązanie eksperymentalne, obecnie zamknięte i wymagające ogromnych zasobów, a pełna ocena jego wartości będzie możliwa dopiero po niezależnych testach. Jeśli deklarowane osiągnięcia zostaną potwierdzone, AlphaEvolve może stać się kamieniem milowym w rozwoju samoewoluującej sztucznej inteligencji, potencjalnie przyspieszając postęp w wielu dziedzinach nauki i technologii.

Źródła:

Oficjalny blog: Google DeepMind (2025) deepmind.google deepmind.google deepmind.google

VentureBeat (2025) venturebeat.com venturebeat.com

Scientific American (2025) scientificamerican.com scientificamerican.com

IEEE Spectrum (2025) spectrum.ieee.org spectrum.ieee.org

InfoQ (2025) infoq.com infoq.com